Este es el primero de 4 reportajes cuyo objetivo es entender lo que es la Inteligencia Artificial (IA); desde el origen de las computadoras electrónicas, pasando por los programas, datos, aplicaciones, definición y componentes, hasta el futuro de la IA, analizando los mitos, oportunidades y riesgos que representa esta tecnología, identificando cada una de sus partes.

Historia de la computadora. Cuando hablamos de computadoras asociamos a equipos electrónicos de cálculos que día a día son más sofisticados y complejos y que apoyan prácticamente a todas las actividades de los seres humanos, y que cada día evolucionan a pasos agigantados, exponencialmente. Sin embargo, en sus inicios no fue así.

El principio básico de una computadora es que es un ordenador, es decir, una herramienta de cálculos más eficientes que si intentáramos procesar la información requerida para obtener un resultado en forma manual, haciendo posible, a través de ellas, agilizar los procesos cotidianos, obteniendo información en forma ordenada, además de permitirnos avanzar no solo en el ordenamiento, almacenamiento y procesamiento de la información sino que adicional mente nos permiten tomar decisiones basadas en los resultados que obtenemos a partir de ellas, a tal grado que la calidad de vida que tenemos hoy en día sería impensable sin ellas.

Los antecedentes de la computadora, hasta donde conocemos actualmente con lo descubierto en la historia reciente, se remontan al año 4.000 a. C. cuando se inventaron las primeras máquinas diseñadas para la astrología, la aritmética y las primeras reglas de cálculo, entre ellas, el ábaco.

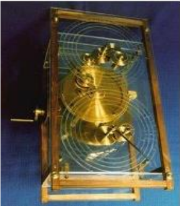

El mecanismo de Anticitera es una computadora analógica (o mecánica) de la antigüedad. Supuestamente construido por científicos griegos, el instrumento se data hacia el año 200 a. C. El componente fue recuperado en el mar Egeo, entre los años 1900 y 1901, de un antiguo naufragio cercano a la isla griega de Anticitera. Este artefacto aparentemente fue diseñado para predecir posiciones astronómicas y los eclipses de hasta diecinueve años con propósitos astrológicos y calendáricos, y predecir también la fecha exacta de seis certámenes griegos antiguos, entre los que se encuentran los cuatro principales juegos Panhelénicos y dos juegos más de menor reconocimiento.

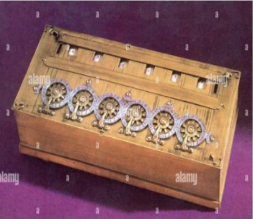

Posteriormente se crearon inventos más sofisticados, como la máquina de Blaise Pascal (conocida como Máquina de Pascal o Pascalina), creada en 1642. Consistía en una serie de engranajes que permitían realizar operaciones aritméticas mecánicamente.

Al mejorarla, en 1671 Gottfried Leibniz dio inicio a las primeras calculadoras, acercándose a lo que es un computador, pero en forma mecánica. En 1802 Joseph Marie Jacquard inventó un sistema de tarjetas perforadas que le permitiría automatizar sus telares y reducir así la necesidad de mano de obra.

En 1822 fueron la inspiración del inglés Charles Babbage en la creación de una máquina de cálculo diferencial.

Pero las máquinas analógicas por sí mismas simplemente eran instrumentos mecánicos con engranajes sofisticados que, basados en engranajes o interpretaciones, permitían obtener resultados. Se necesitaban las bases para que los resultados de estos instrumentos, introduciéndoles diferentes datos de entrada, pudiesen procesarlos a través de un ‘lenguaje formal’ y obtener otros resultados, lo que se denomina en inglés Input -> Process -> Output, donde cada uno de ellos es, en sí mismo, un proceso: la entrada de los datos (ordenados, normalizados), la certeza de que son correctos, el procesamiento a través de un algoritmo y un lenguaje que lo interprete, obteniendo una salida de datos que nos permita tomar decisiones.

Si los datos de entrada no son correctos, si el ‘algoritmo’ está mal conceptualizado o diseñado, los resultados y, por consiguiente, la toma de decisiones que se ejecute a partir de ellos, también serán incorrectos.

Pero, ¿qué es un algoritmo? En informática, se llaman algoritmo al conjunto de instrucciones sistemáticas y previamente definidas que se utilizan para realizar una determinada tarea. Estas instrucciones están ordenadas y acotadas a manera de pasos a seguir para alcanzar un objetivo; un buen análisis de un algoritmo se basa en la elaboración de diagramas de flujo de procesos, donde se aplica la lógica.

Los inicios del cómputo tal como lo conocemos en nuestros días.

La llamada ‘Máquina de Turing’ es, en realidad, un modelo matemático consistente en un autómata capaz de ‘implementar cualquier problema matemático expresado a través de un algoritmo’. A pesar de esta definición tan complicada, en realidad la máquina de Turing destaca por su simplicidad, pues manipula símbolos sobre una tira de cinta, siguiendo una serie de reglas.

A pesar de esta simplicidad, una máquina de Turing puede adaptarse para simular la lógica de cualquier algoritmo de un computador, de ahí su enorme potencial y valor.

La máquina de Turing fue creada por el matemático inglés Alan Turing, un genio en muchos campos, pero especialmente en la criptografía y la lógica. Originalmente la denominó ‘Máquina de Computación Lógica’, siendo una de las mayores aportaciones pues despejó el camino de la ciencia de la Computación, de la Informática moderna.

Posteriormente, Noam Chomsky, nacido en 1928 en Filadelfia, profesor de lingüística en el MIT, Estados Unidos, y una de las figuras más destacadas de la lingüística del siglo XX, entre su contribución científica podemos destacar una aportación fundamental a la lingüística moderna, consistente en la formulación teórica y el desarrollo del concepto de gramática transformacional y generativa.

Esta contribución perfeccionó los trabajos de otros maestros del MIT, creando técnicas para el análisis científico del significado, dando origen a una verdadera revolución en el campo de la lingüística, incorporando el concepto de transformación a la lingüística, apartándose del estructuralismo y del conductismo imperantes hasta entonces.

En cuanto a la relación de Chomsky con la informática, proviene de sus importantes aportaciones a la teoría de autómatas y al estudio de los lenguajes formales.

Dichas aportaciones han resultado elementos indispensables para la construcción de compiladores y traductores que puedan servir de intérpretes válidos entre las órdenes que dan los seres humanos y su correcta recepción y aplicación por máquinas automáticas.

Puede decirse que el papel desempeñado por Chomsky ha resultado crucial en este importante campo, pues fue imprescindible para dar el siguiente paso tras los primeros computadores, el ENIAC o el propio ACE de Alan Turing, programados directamente en código binario, de forma que a mediados de 1954 su obra ya influyó en la especificación del borrador para el lenguaje Fortran (ver parte 2 del documento), entre otras aplicaciones.

La máquina de Turing es considerada un autómata con la capacidad de reconocer lenguajes formales de acuerdo a la jerarquía de Chomsky, razón por la cual es muy superior a otros autómatas.

Breve historia de la Computación.

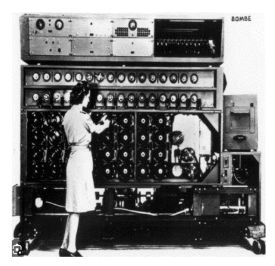

- Primera generación (de 1940 a 1952):

Las tarjetas perforadas suministraban instrucciones a las primeras máquinas. La generación inicial de computadoras inicia con la invención de las primeras máquinas de cálculo automáticas, que podían considerarse propiamente un ‘computador’. Respondían a la necesidad durante la Segunda Guerra Mundial de descifrar códigos secretos enemigos. Estaban basadas electrónicamente en válvulas y tubos al vacío. Podían programarse mediante un conjunto de instrucciones simples, que debían suministrarse al sistema a través de tarjetas perforadas de papel o de cartón, como en el invento de Charles Babbage.

- Segunda generación (de 1956 a 1964):

La segunda generación representó un cambio importante, ya que se sustituyeron las válvulas de vacío por transistores, permitiendo hacer las máquinas mucho más pequeñas y reduciendo además su consumo eléctrico. Estas fueron, también, las primeras máquinas en disponer de un lenguaje de programación, como el lenguaje FORTRAN. Así, pronto se hizo obsoleto el sistema de las tarjetas perforadas.

- Tercera generación (de 1965 a 1971):

Los circuitos integrados iniciaron la miniaturización de las computadoras. El salto a la tercera generación estuvo determinado por la invención de los circuitos integrados: permitieron aumentar la capacidad de procesamiento de las máquinas y, por si fuera poco, reducir sus costos de fabricación. Se trataba de circuitos impresos en pastillas de silicio, con pequeños transistores y semiconductores incorporados. Este fue el primer paso hacia la miniaturización de las computadoras.

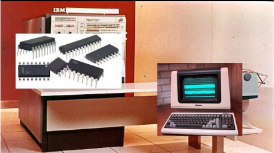

- Cuarta generación (de 1972 a 1981):

Los microprocesadores aparecieron con las primeras computadoras personales. La paulatina integración de los anteriores componentes electrónicos propició la aparición de los microprocesadores: nuevos circuitos integrados que reúnen todos los elementos fundamentales de la computadora y que empezaron pronto a llamarse chips. Gracias a ellos, las computadoras podían descentralizar sus operaciones lógico-aritméticas. Por ejemplo, reemplazar la memoria de anillos de silicio por memoria de chips, fue un paso importante hacia la micro computarización. A esta generación pertenecieron las primeras computadoras personales o PC.

- Quinta generación (1981-1989):

La quinta generación es un proyecto hecho en Japón que comenzó en 1981. Su objetivo era el desarrollo de una nueva clase de computadoras que utilizarían técnicas y tecnologías de inteligencia artificial tanto en el plano del hardware como del software.

Usando el lenguaje serían capaces de resolver problemas complejos, como la traducción automática de una lengua natural a otra (del japonés al inglés, por ejemplo). Como unidad de medida del rendimiento y prestaciones de estas computadoras se empleaba la cantidad capaz de realizar durante la ejecución de las distintas tareas programadas (multitareas o multiprocesos). Para su desarrollo se emplearon diferentes tipos de arquitecturas.

- Sexta generación (1990-1998):

Esta generación abarca desde 1990 hasta 1998, en esos tiempos crearon una computadora llamada NeXTstation que servía para jugar, estudiar y lo más importante, trabajar. Salió a la venta, para computación ‘interpersonal’, como lo describió Steve Jobs, su creador.

El NeXTstation se pretendía que fuera un computador para los años 1990, y fue una versión más barata que el previo NeXT Computer. En mayo de 1998, Steve Jobs se presentó ante periodistas, accionistas y consumidores con la intención de cambiar el mundo con su nueva computadora, el primer iMac de Apple.

La primera iMac consiguió romper con la monotonía de los PCs de Microsoft y hasta de la propia Macintosh, con un aspecto compacto y color beige. La imagen de la nueva máquina de Apple ofrecía un diseño en forma de huevo, con una carcasa transparente que dejaba ver sus entrañas y se ofrecía en diferentes y divertidos colores. También tenía un asa en la parte superior que permitía una mejor movilidad.

Además, el iMac fue el primer computador todo en uno, donde hardware y software se encontraban en un mismo sitio. Lo único que se conectaba al ordenador eran el teclado y el ratón, sin necesidad de torres.

- Séptima generación (1999-actualidad):

La séptima generación comienza en el año 1999, donde popularizan las pantallas planas LCD y hacen a un lado a los rayos catódicos, dejando los DVD y los formatos de disco duro óptico. La nueva generación de almacenamiento de datos de alta densidad tiene una capacidad de almacenamiento que llega a los 50 GB, aunque se ha confirmado que esta cifra puede recibir 16 capas de 400 GB.

Son más pequeñas y versátiles, así como las pantallas táctiles, los libros electrónicos, tablets, móviles de última generación e infinidad de dispositivos electrónicos, como los reproductores de música y vídeo en mp3 y mp4 u otros formatos, las cámaras de fotos digitales, los discos duros externos y las memorias flash o USB, incluso las pantallas planas de alta resolución.

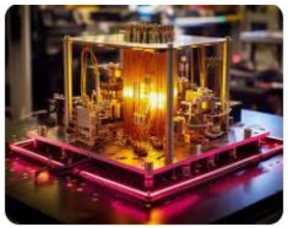

El cómputo Cuántico

Un ordenador cuántico es un tipo de ordenador que utiliza la mecánica cuántica para realizar ciertos tipos de cálculos de forma más eficiente que una computadora normal.

Es un modelo informático que hace uso de las leyes de la mecánica cuántica para procesar datos. La computación cuántica usa bits cuánticos, o qubits, que pueden representar un uno, un cero o ambos a la vez, en contraste con los dígitos binarios que usa la computación clásica (verdadero o falso, 2 estados).

Primero debemos saber cómo una computadora normal almacena información. Un ordenador normal almacena información en una serie de 0 y 1. De esta manera se pueden representar diferentes tipos de información, como números, texto e imágenes. Cada unidad de esta serie de 0 y 1 se denomina bit. Un bit se puede establecer en 0 o 1.

Un ordenador cuántico no usa bits para almacenar información. En su lugar, utiliza algo llamado qubits. Cada qubit no solo se puede establecer en 1 o 0, sino que también se puede establecer en 1 y 0. Un qubit es el portador físico de la información cuántica y puede tomar valores de cero, uno o ambos a la vez. Los ordenadores clásicos codifican información en bits, mientras que las computadoras cuánticas usan qubits. Cada qubit puede representar un 1 y un 0 al mismo tiempo.

Usando qubit, las computadoras cuánticas pueden contener más información que las computadoras clásicas y resolver problemas de manera más rápida y eficiente.

¿Cómo funciona un ordenador cuántico?

Los ordenadores clásicos no tienen suficiente poder de procesamiento para resolver problemas históricamente intratables. Entonces, con la introducción de ordenadores cuánticos que funcionan con máquinas clásicas a través de la nube, podría ser la respuesta para estos y otros problemas en los que aún no hemos pensado en campos como los productos farmacéuticos, los servicios financieros y la logística.

¿En qué se diferencian los ordenadores cuánticos de los ordenadores tradicionales que estás usando hoy?

Los ordenadores cuánticos tienen el potencial de resolver problemas complejos del mundo que están más allá del alcance incluso con las supercomputadoras de hoy, por ejemplo:

- Puede conducir al descubrimiento de nuevos medicamentos y materiales al descifrar las complejidades de las interacciones moleculares y químicas.

- Pueden ayudar a las industrias financieras a realizar mejores inversiones al encontrar nuevas formas de modelar los datos financieros y aislar los factores de riesgo globales.

- Pueden transformar la cadena de suministro y la logística encontrando la ruta óptima a través de los sistemas globales.

Los nuevos ordenadores cuánticos no reemplazarán a tu portátil o PC actual (de escritorio o portátil), pero abrirán un nuevo universo de información y capacidad para resolver problemas complejos.

Poco se sabe de la generación de computadores por venir, pero lo podemos imaginar. Los grandes adelantos en materia de IA, computación cuántica y algoritmos de aprendizaje, prometen un futuro altamente automatizado y de enormes potenciales industriales en prácticamente cualquier área y tarea.

Fuente: https://concepto.de/historia-de-la-computadora/#ixzz8JFTpXcTL https://es.wikipedia.org/wiki/Generaciones_de_computadoras

El cómputo en la nube

El cómputo en la nube o Infraestructura como servicio, ‘Infraestructure as a Service (IaaS)’ como se conoce en inglés, es el uso en renta de equipo de cómputo a través de Internet. Normalmente, estos servicios suelen pagarse por minutos o por segundos, lo que los hace muy atractivos si solo ocupamos ciertas capacidades de forma limitada. Hoy en día, existen diversos proveedores de estos servicios como Amazon, Microsoft, Google, IBM, entre otros.

El cómputo en la nube, es hoy en día, una opción muy atractiva para desarrollos basados en IA.

Aquí tenemos algunos ejemplos:

- Para el desarrollo de modelos de IA, frecuentemente se requiere cómputo de alto desempeño, el cual es costoso de adquirir y mantener, si no se aprovecha correctamente y la mayor parte del tiempo está ocioso. Con el cómputo en la nube es posible rentar equipo con estas capacidades solo por el tiempo que sea necesario, reduciendo los costos de realizar este tipo de inversiones. Además, el espacio de almacenamiento y acceso a grandes volúmenes de información, prácticamente ilimitado y disponible en todo momento dentro de las reglas de acceso a la misma, pública o privada, se pueden considerar en este mismo modelo, con sus unidades de medida.

- Además de renta de equipo de cómputo, también existen herramientas que se instalan en estas máquinas y que permiten hacer desarrollos de IA más rápidos. Esto permite que empresas no especializadas en IA, puedan acceder a este tipo de capacidades.

- Los proveedores de cómputo en la nube también ofrecen herramientas para configurar servicios web de forma rápida y segura, lo que permite que los modelos de IA se puedan desplegar con poco tiempo de despliegue.

El tiempo estimado de las innovaciones en la tecnología de cómputo era de 18 a 24 meses hasta antes de la pandemia, siguiendo la Ley de Moore.

Esta ley sugiere que la cantidad de transistores en un microprocesador se duplica aproximadamente cada dos años, lo que impulsa avances significativos en la capacidad de procesamiento y otros aspectos de la tecnología de cómputo.

Sin embargo, este ritmo puede variar según diversos factores, como avances en investigación y desarrollo, demanda del mercado, innovaciones tecnológicas disruptivas, entre otros, por ejemplo, como ha ocurrido con la pandemia del COVID donde se han desarrollado múltiples aplicaciones de comunicaciones y procesamiento remoto que demandan más poder de cómputo, local y móvil.

[…] otras palabras, es un lenguaje que permite a los programadores comunicarse con las computadoras para decirles qué […]